De hype a realidad: Nvidia toma la delantera en el juego de la IA 🚀

Cómo una buena estrategia marca la diferencia y porqué todo el mundo no lo hace igual de bien

¡Bienvenidos una vez más a la newsletter de Innovation by Default 💡!

Una semana más, y ya van treinta y una semanas en lo que llevamos del año, y de nuevo Álex Fuenmayor (@adefuros) al timón de esta nave. Espero que hayas tenido una vuelta más relajada en caso de que hayas regresado de tus vacaciones. Si todavía estás disfrutando de ese merecido descanso, espero que estés aprovechando al máximo cada momento.

Esta semana me gustaría hablar sobre el que en mi humilde opinión, uno de los temas más candentes en la industria tecnológica en los últimos años, enconcreto la adopción y los avances en torno a la IA. La IA generativa y los modelos de difusión han dado un salto cuantitativo que ha impactado de manera significativa. Prácticamente ningún sector o profesión está viendo este gran avance como solo una oportunidad; también lo perciben como un desafío considerable.

Y al igual que sucedió en la fiebre del oro, quienes más ganaron en su momento fueron los fabricantes de picos y palas. Y de nuevo, en esta burbuja, parecen ser los fabricantes, en este caso de GPUs, quienes más ganarán del hype en torno a la IA generativa. Y aquí en concreto tenemos un claro ganador: Nvidia.

Si comparamos con el resto de fabricantes, ¿qué ha diferenciado a Nvidia de AMD o a uno de los pioneros del Valle del Silicio, como es Intel? A primera vista, parece que la estrategia de Nvidia es, sin duda alguna, la más adecuada para el mundo de la computación que se presentaba ante nosotros hace unas décadas. En aquel momento, la IA parecía estancada en un nuevo invierno, empezaban a perfilarse tendencias como el blockchain y su famoso bitcoin, y estaba claro que el video iba a convertirse en el formato dominante de la internet en el siglo XXI. Y todo ello, tuvo un avance increible gracias al uso de las GPUs.

Dice Richard Rumelt, que no hemos de confundir estrategia con fijación de objetivos, ya que la estrategia en sí debe incluir información precisa sobre cómo se alcanzarán realmente esos objetivos. En definitiva en un plan de acción, no hace falta el qué, sino el cómo. Y sí, parece que el "cómo" de Nvidia ha sido más exitoso que el de los demás.

De hecho, Rumelt dedica un capítulo de su famosísimo libro "Good Strategy/Bad Strategy" a desentrañar, utilizando el ejemplo de Nvidia entre otros, qué constituye una estrategia exitosa y qué no.

Así que dejame que esta semana esbocemos qué hace diferencial a un estrategia ganadora, y cómo Nvidia ha sido capaz de construir la suya.

Suscríbete para leer esta y otras muchas historias sobre innovación, tecnología y negocios.

Si no se define el reto, es difícil o imposible evaluar la calidad de la estrategia

Si trabajas en la industria tecnológica, los acrónimos y los buzzwords son un lastre para el resto de los mortales. Poner nombre a todo y utilizar tecnicismos genera una barrera de entrada significativa. Pero parece que el mundo de las TIC no es el único lugar donde estos malos hábitos existen. Según Rumelt, los eslóganes motivacionales y las palabras de moda también a veces se hacen pasar por estrategias. Este es el primer punto del decalogo de Good Strategy, Bad Strategy que he construido para vosotros.

“Si no tienes un plan de acción, entonces no tienes estrategia.” - Richard Rumelt.

Además toda buena estrategia tiene siempre la misma base: un diagnóstico, una política rectora y un conjunto de acciones coherentes.

Pero como te decía estos son parte de los diez momentos más brillantes del libro, que te dejo a continuación:

Falsas estrategias: Los eslóganes motivacionales y las palabras de moda a veces se confunden con estrategias. Esto también ocurre con tecnicismos y malos enfoques científicos o tecnológicos.

Componentes esenciales de una estrategia: Una estrategia efectiva requiere un plan de acción.

El núcleo de una estrategia: El núcleo estratégico consta de tres partes: diagnóstico, política rectora y conjunto de acciones coherentes.

Anticipación y visión: La anticipación se trata de reconocer oportunidades emergentes basadas en la comprensión del presente, no de predecir el futuro.

Maximización de ventajas competitivas: Una estrategia efectiva aprovecha la ventaja competitiva al utilizar recursos de manera eficiente y limitar las oportunidades de los competidores.

Mecanismos de aislamiento: La ventaja competitiva se puede lograr mediante mecanismos de aislamiento, como marcas fuertes o servicios complementarios.

Enfoque científico de la estrategia: Desarrollar hipótesis estratégicas y probarlas puede llevar a un enfoque efectivo en la estrategia.

Aprendizaje de los demás: Las buenas estrategias se basan en observar y aprender de las experiencias y lecciones de otros en situaciones similares.

Efectividad del equilibrio entre recursos y acciones: Las mejores estrategias reconocen el equilibrio entre los recursos disponibles y las acciones posibles, optimizando ambos.

Creación de cambios a través de la innovación: En mercados donde las mejoras tecnológicas son costosas, la innovación puede ser crucial para generar cambios y aprovechar oportunidades.

Una de las anecdotas más famosasque se recogen en el libro es la conversación que tuvo lugar en 1998, cuando Rumelt se reunió con Steve Jobs poco después de que éste regresara a Apple tras su exilio en NeXT Computer. Cuando el profesor le preguntó por su estrategia a largo plazo, sonrió y dijo: "Voy a esperar a la próxima gran cosa", que resultó ser el reproductor de música portátil iPod.

Una buena estrategia exige que elijas avanzar en una dirección concreta, la estrategia es renunciar.

Y parece que esa renuncia y foco, exige priorizar lo más importante y concentrar los recursos en ello. Algo que apriori podemos pensar que también ha sabido implementar Nvidia de forma exitosa, y como veremos en el siguiente apartado.

Desgraciadamente, las decisiones difíciles suelen perjudicar a otras áreas de la empresa, por lo que encuentran una fuerte oposición.

Por ejemplo, Intel se vio obligada a tomar decisiones difíciles después de que muchas empresas japonesas en el mercado de los dispositivos para ordenadores clónicos dificultaran su situación al competir en diversos frentes. En ese momento, su Consejero Delegado, Andy Grove, se vio forzado a tomar una decisión y redirigir el enfoque de la empresa hacia la fabricación de microprocesadores.

Este cambio se encontró con la oposición de muchas áreas de la empresa, incluidos los vendedores e investigadores, que estaban apegados a los viejos hábitos y procesos.

Aunque hubiera sido menos estresante dar marcha atrás ante la oposición, Grove perseveró en esta nueva dirección. En 1992, Intel era el mayor fabricante de semiconductores del mundo. Esta misma anecdota, se reoge en el libro “Mide lo que importa”, donde John Doer desgrana el nacimiento de los OKR y su despliegue en Intel. Y la renuncia y foco que tuvo que hacer Intel, renunciando a la fabricación de memorias en favor de los fabricantes japoneses.

La carrera por los chips que gobiernen la IA

Como dije al comienzo de esta edición, parece que Nvidia se ha convertido en uno de los primeros ganadores del auge de la IA generativa.

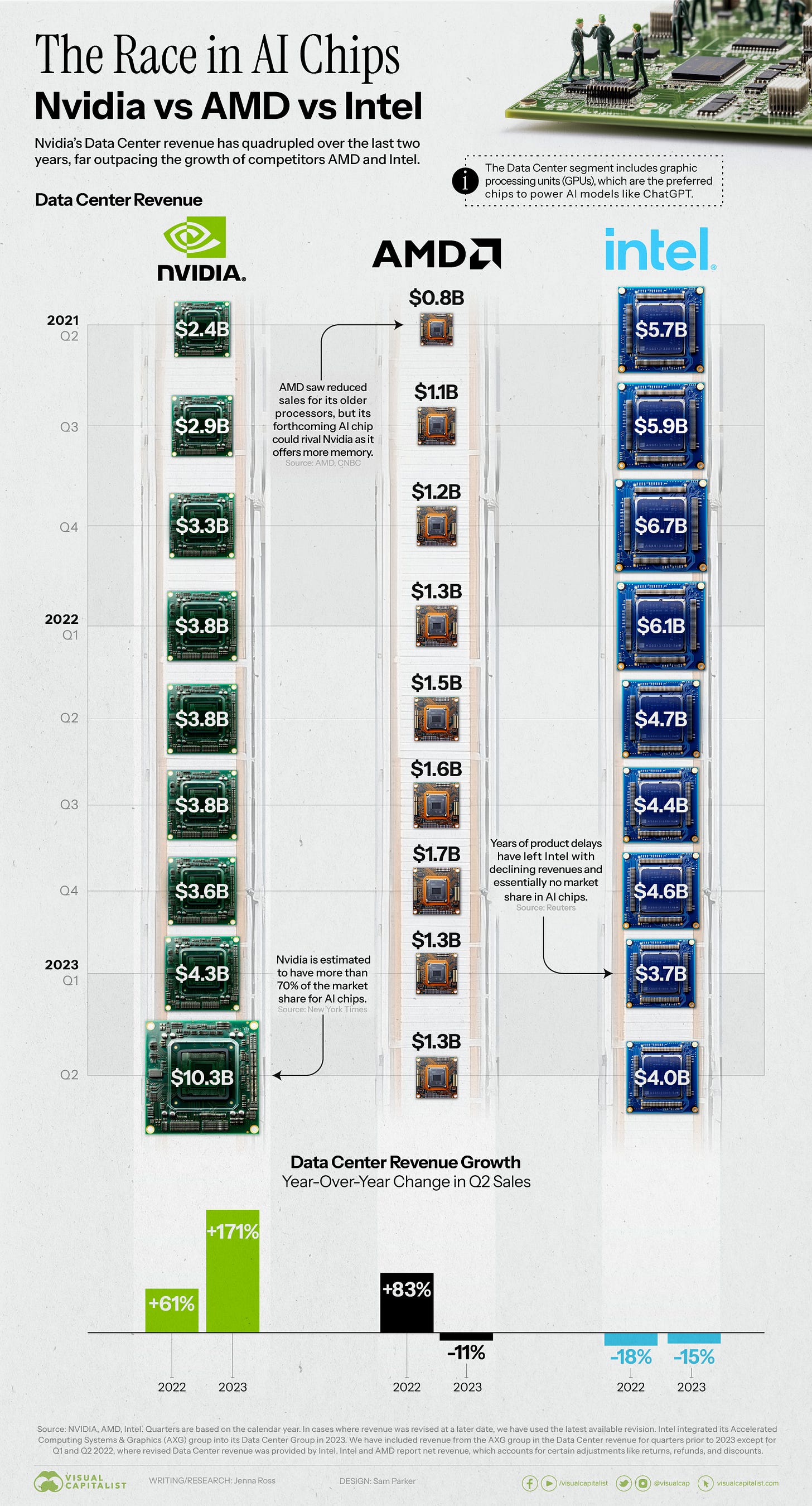

Si miramos el único indicador que importa para la bolsa, Nvidia reportó ingresos récord en su informe de resultados del segundo trimestre, donde las ventas de chips de IA jugaron un papel fundamental. Si comparamos con los otros dos líderes de la industria de los chips para centros de datos, ¿cómo quedan las ventas de chips de IA de Nvidia en comparación con las de AMD e Intel?

Como se suele decir, las comparaciones son odiosas, pero gracias a la especialización en la fabricación de GPUs por parte de Nvidia, ha conseguido duplicar sus ventas en solo un trimestre y casi triplicar las ventas de Intel.

Si te gusta lo que estas leyendo, no olvides que también tienes disponible el podcast de Innovation by Deafult 💡.

Aunque esta semana no tenemos edición de audio, puedes escuchar alguno de los capítulos anteriores.

Lección bien aprendida, tarde o nunca se olvida

Hagamos un repaso junto a Richard Rumelt de cóm Nvidia ha sido capaz de jugar sus cartas mejor que el resto de sus competidores, especializandose en la fabricación de un hardware determinado, y entender como ha sido capaz de ver y adelantarse a las señales del mercado como ningún otro jugador en el terreno de juego del silicio.

Así que empecemos por el principio, Nvidia fundada en 1993 por Jen-Hsun Huang, Curtis Priem y Chris Malachowsky. Inicialmente, a finales del siglo XX, la industria estaba llena de conversaciones sobre la inminente revolución multimedia. Sin embargo, las tarjetas de audio existentes carecían de compatibilidad, no existía un estándar para la compresión o visualización de video, y tampoco había un estándar para gráficos en 3D.

Por aquel entonces, Microsoft Windows 95 y el uso generalizado de Internet aún estaban a años de distancia. El primer producto de la compañía, el NV1, introducido en 1995, tenía como objetivo establecer un nuevo estándar multimedia, pero se dió de bruces con las limitaciones en capacidades de audio y no logró ganar tracción en gráficos en 3D. Esto resultó en lo que fue un fracaso comercial. Ante esto y el ascenso de su competencia (3dfx), Jen-Hsun Huang redefinió la estrategia de la compañía con aportes de un consejo asesor técnico. La nueva estrategia cambió el enfoque de multimedia a gráficos en 3D para PC de escritorio.

Nvidia abandonó sus desarrollos propietarios y adoptó estandares de facto del mercado como el graphic pipeline desarrollado por SGI. La premisa fundacional de ser una empresa de chips "sin fábrica", enfocada en diseño y subcontratación de fabricación, se mantuvo sin cambios. Durante los siguientes años la ley de Moore hizo su parte y el tamaño de los procesadores continuo reduciendose. Este hecho ayudo a Nvidia a mejorar el rendimiento de los gráficos en 3D. Lo que permitió que sus diseños de chips incorporaran más pipelines gráficos en un solo chip y agregar procesadores en paralel para aumentar el rendimiento. Su premisa era que el mercado demandaba más potencia de procesamiento gráfico, así al menos lo creia su científico jefe David Kirk conocedor de las limitaciones del momento de la arquitectura de los PCs de la época.

En resumen, Nvidia reconoció la creciente demanda de potencia de cómputo gráfico y la importancia de la GPU en la tecnología y el valor añadido que aportaba en la informática de consumo a través de sus tarjetas gráficas. Pero la forma más sencilla de entender la potencia gráfica de una GPU vs un CPU la puedes encontrar en el siguiete video.

Para el lenguaje gráfico, la dirección de Nvidia optó por no trabajar con Glide de 3dfx, apostando en su lugar por la nueva y no probada tecnología DirectX de Microsoft. El CEO Jen-Hsun Huang creía que podían obtener una ventaja al romper el ciclo de dieciocho meses de la industria, ofreciendo actualizaciones sustanciales en potencia gráfica cada seis meses. El equipo de Nvidia diseñó políticas y procesos de diseño para convertir esta política en realidad. La primera acción fue establecer tres equipos de desarrollo separados manteniendo un plan a dieciocho meses como el dfe facto del mercado, que se superponían para entregar un nuevo producto cada seis meses.

Los retrasos eran más problemáticos en un ciclo de seis meses que en uno de dieciocho meses, por lo que el foco se puso en cómo reducir y disminuir la incertidumbre en el proceso de desarrollo. Nvidia invirtió en técnicas de simulación y emulación para abordar los posibles retrasos causados por errores de diseño. Además, se simularon las características eléctricas del chip para prevenir problemas en su funcionamiento físico. Además, la contribución a la arquitectura de ordenadores de Nvidia fue factor importante de su éxito, tomando el liderazgo de la creación y gestión de controladores de software para los chips y desarrollando una arquitectura de controladores unificada (UDA).

Otro de los aspectos diferenciales de la estrategia de Nvidia fue su un enfoque en el desarrollo de un software único de controladores para todas sus tarjetas, descargable fácilmente desde Internet. El software se adaptaría a cada chip, ajustando los comandos según las capacidades del chip, lo que simplificaría el proceso para los usuarios y permitiría a Nvidia tener control sobre la construcción y distribución de controladores. La inversión en instalaciones de emulación (como los túneles de viento en la F1) aceleró el desarrollo de controladores, permitiendo que el desarrollo comenzara antes de que los chips reales estuvieran disponibles.

Este ciclo de desarrollo rápido consigió no solo más frecuencia en la entrega de modelos sino también en las innovaciones que incorporaban cada uno de estos.

La estrategia culminó en el lanzamiento de chips superventas como el RIVA TNT y el GeForce 256, este último con un rendimiento excepcional y la capacidad de ejecutar múltiples operaciones de gráficos en un solo chip.

Al no controlar el proceso completo de fabricación, Nvidia se centró en resolver problemas de retrasos, problemas de controladores y costos adicionales causados por los proveedores que fabricaban sus placas a medida. Intentaron negociar con Diamond Multimedia y luego con Dell para cambiar la relación con los fabricantes de placas. Finalmente, se asociaron directamente con fabricantes de electrónica general como Taiwan Semiconductor Manufacturing Co. y Korea's Samsung Electronics. La estrategia de Nvidia alteró la relación entre los fabricantes de chips y los de placas, permitiendo un enfoque más cohesivo en el proceso de desarrollo.

Parece que centrarse en sus fortalezas como el diseño, y trabajar con un tercero capaz de especializarse en la fabricación, es parte del éxito no solo de Nvidia sino también de Apple. Diseñado en California/Fabricado en China

Las consecuencias de está estrategia es la habitual, the winners take all, competidores como 3dfx no pudieron mantenerse al día con los ciclos de desarrollo impuestos por Nvidia, y acabo siendo absorvida por esta última. Intel también tuvo dificultades para competir en el mercado de gráficos 3D de alto rendimiento, debido a su ciclo de desarrollo más lento y su enfoque en los procesadores. Aunque tuvo éxito en el mercado de gráficos 2D, no pudo mantener los ciclos de innovación de Nvidia para el mercado de gráficos 3D.

La estrategia del otro gigante del mercado de la computación de gráficos 3D, Silicon Graphics (SGI), se centró en la adquisición de empresas de estaciones de trabajo y servidores, no funcionó ya que no supo leer por donde iba el mercado y la creciente competencia de las estaciones de trabajo basadas en Windows-Intel hizo que el mercado se abaratase. SGI, nunca ataco el mercado de consumo para gráficos 3D en PC. Su enfoque en el crecimiento por sí solo, sin abordar los desafíos reales de la informática de consumo, llevó a la empresa a la bancarrota en 2006.

Durante eso años, emergió un nuevo competidor, ATI Technologies, adapatando los ciclo de lanzamiento impuestos por Nvidia. Otro de los competidores surgidos por aquel entonces fue ArtX, formado por ex ingenieros de Silicon Graphics, que tampoco fue capaz de seguir el ritmo de Nvidia y adquirida por ATI en febrero del 2000. Finalmente en 2006, AMD se fusionó con ATI, consolidando aún más la competencia.

A pesar de su éxito en la estrategia entre 1998-2008, según recoge Rumelt en su libro, Nvidia enfrenta nuevos desafíos y busca expandirse con iniciativas como la plataforma Tesla para supercomputación y Tegra para dispositivos móviles. Sin embargo, estas líneas de trabajo hemos visto que han presentado serías dificultades y no han contribuido de forma diferencial al éxito de la compañía en los últimos años.

Yo añadiría y señalaría también como parte del éxito de Nvidia en los últimos años, la construcción de un ecosistema de herramientas de software y diferentes modelos, como parte de la adopción y explosión másiva del mercado de la IA y el ML.

Food for thought

Por suerte, todos podemos aprender a ser buenos estrategas. hay que desarrollar una serie de habilidades y saber leer entre línas, y comprender el terreno de juego donde quieres competir.

En su libro Good Strategy/Bad Strategy, Richard Rumelt nos ejemplifica en qué consiste una estrategia sólida y nos enseña a encontrar el poder oculto de una situación dada. Ya sea aprovechando, maximizando nuestros recursos o anticipandonos al cambio de nuestro mercado.

Así que para terminar, dejame cerrar con tres de los consejos que mas me han llamado la atención del libro.

Ordena tus prioridades: Intentar alcanzar todos los objetivos a la vez es una estrategia ineficaz. En su lugar, crea una lista con las cosas más importantes en las que puede trabajar y empiece por ellas primero. Al crear esta lista, te aseguras de que tus diferentes objetivos están alineados en la misma dirección, lo que te permite resolver posibles conflictos llegado el caso de una manera más sencilla.

Aprende del pasado: Si te encuentras en una situación que otras personas han vivido anteriormente, presta mucha atención a cómo les resultó a ellos. Intenta analizar tu propia situación con objetividad en lugar de suponer que es diferente de lo que ocurrió en el pasado.

Piensa como un científico: Si no estás seguro de cuáles son los factores decisivos en una determinada situación, formula una hipótesis y ponla a prueba. Esta prueba te dara las pistas sobre qué áreas necesitan reajustarse, dandote una mejor comprensión del problema y que podrá utilizar para construir una estrategia eficaz.