El precio real del progreso en IA

Diario de Innovación #279

Cuando hablamos de avances en inteligencia artificial solemos mirar una cosa: los benchmarks.

Más puntos.

Más rankings.

Más gráficas ascendentes.

Y, sin embargo, casi nunca miramos la variable que decide si todo eso importa fuera del laboratorio: el precio.

Hoy quiero detenerme en un paper reciente que pone el dedo justo ahí. No discute si los modelos son más listos o más creativos. Discute algo más incómodo:

¿Cuánto cuesta hoy hacer lo que ayer parecía imposible?

Y la respuesta es tan prometedora como engañosa.

Durante los últimos años hemos visto progresos espectaculares en matemáticas, razonamiento o programación.

Pero hay un detalle que suele desaparecer del relato.

Muchos de esos saltos no vienen de modelos mejores, sino de modelos:

más grandes

más lentos

más caros

con razonamientos mucho más largos

Si solo miramos la puntuación final, confundimos progreso técnico con consumo de computación.

Es como celebrar que un coche corre más sin mencionar que ahora consume el triple.

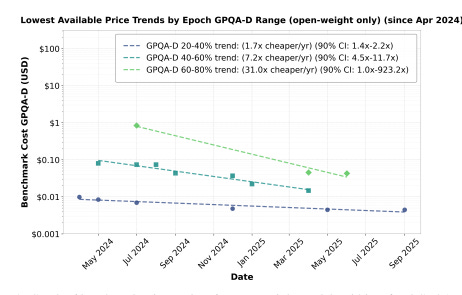

Este paper propone cambiar la pregunta:

No “qué score consigue el modelo”, sino cuánto cuesta alcanzar ese score.

Los autores combinan datos históricos de precios de inferencia con resultados de benchmarks reales (conocimiento, matemáticas y software).

No miran el precio por token.

Miran algo mucho más honesto: el precio total de ejecutar un benchmark completo para un nivel concreto de rendimiento.

Además:

Se centran en la frontera eficiente (el modelo más barato para cada nivel de calidad)

Separan modelos abiertos y cerrados para aislar efectos de mercado

Ajustan por la caída de precios del hardware

El objetivo es claro: estimar cuánto del progreso es realmente algorítmico.

Aquí viene el dato que muchos usarán como munición optimista: para un mismo nivel de rendimiento, el coste de inferencia cae entre 5× y 10× al año.

En algunos tramos altos, incluso más.

Es decir:

Lo que hoy cuesta 10 euros

mañana cuesta 2

y pasado mañana, céntimos

A primera vista, esto suena a democratización acelerada.

Pero aún no hemos terminado.

Cuando los autores aíslan:

modelos de pesos abiertos

y descuentan la mejora del hardware

queda algo muy interesante: el progreso puramente algorítmico ronda un factor 3× anual.

Esto significa que:

los modelos hacen lo mismo

con aproximadamente un tercio del cómputo cada año (esto me suena a algo, la Ley del señor Moore)

No es hype.

No es marketing.

Es eficiencia real.

Y también marca un límite: si el crecimiento futuro no puede basarse solo en más GPUs, la eficiencia será el cuello de botella clave.

Aquí llega la parte que casi nadie cuenta.

Aunque ejecutar modelos equivalentes es cada vez más barato, evaluarlos es cada vez más caro.

Los benchmarks actuales:

usan modelos más grandes

generan razonamientos más largos

exploran contextos gigantes

Resultado: evaluar un solo modelo puede costar miles de dólares

Esto tiene consecuencias claras:

grupos académicos pequeños quedan fuera

la evaluación se concentra en actores privados

parte de los datos deja de ser transparente

Paradójicamente:

La IA se abarata pero entenderla se encarece.

El mensaje de fondo no va de precios.

Va de cómo interpretamos el progreso.

Un modelo que mejora mucho un benchmark gastando 10× más cómputo no es un avance equivalente a uno que logra lo mismo con menos recursos.

Si ignoramos el coste:

sobreestimamos capacidades

malinterpretamos tendencias

y alimentamos expectativas irreales

El progreso real es capacidad útil por euro.

Todo lo demás es narrativa.

Los autores cierran con una recomendación que debería ser obvia, pero no lo es: los benchmarks deberían publicar siempre el coste y los recursos usados.

Sin eso:

no sabemos si la IA es realmente más eficiente

no sabemos si sustituye trabajo humano de forma viable

no sabemos si el progreso es sostenible

Medir sin precio es medir a ciegas.

Aunque el paper no menciona a DeepSeek ni a NVIDIA.

Casos como DeepSeek ilustran el tipo de progreso que aquí se intenta aislar: mejoras algorítmicas que permiten hacer lo mismo con mucho menos cómputo.

NVIDIA, en cambio, representa la otra fuerza del sistema: hardware cada vez más potente y eficiente.

Lo interesante es que el estudio intenta separar ambas cosas y llega a una conclusión clara: no todo el progreso viene de más GPUs.

Incluso descontando el efecto del hardware, la eficiencia algorítmica sigue avanzando rápido.

Y eso importa, porque cuando el crecimiento ya no puede apoyarse solo en “más silicio”, la innovación real se mide en cómo usamos mejor cada ciclo, no en cuántos compramos.

🌍 El eco del mercado

🎧 OpenAI prepara su primer dispositivo físico para 2026 (y no será un robot). Según sus propios directivos, el primer hardware de la compañía podría llegar en 2026 y tomar la forma de unos auriculares inteligentes. El movimiento apunta a integrar la IA de forma permanente en la vida cotidiana, reduciendo fricción y dependencia del teclado.

🧒 ChatGPT empezará a estimar tu edad para proteger a menores. La IA ya no solo responde: también evalúa contexto y riesgo. ChatGPT incorporará sistemas para inferir la edad del usuario y limitar contenidos sensibles a menores. Un paso clave hacia el “compliance by design”, aunque abre debates serios sobre privacidad y falsos positivos.

🎥 YouTube permitirá crear Shorts con clones de IA de los creadores. Los creadores podrán generar versiones sintéticas de sí mismos para producir contenido sin estar presentes. Identidad, creatividad y automatización se fusionan. El siguiente debate ya está servido: ¿quién controla al “yo digital” cuando empieza a escalar solo? Espero que pronto veáis el mío. ;)

🧩 Cinco apps open source que funcionan desde el navegador (y sin instalar nada). El software libre vuelve a ganar terreno gracias a la simplicidad. Herramientas web, sin login invasivo ni instalación local, que cubren tareas cotidianas.

⚖️ Snap evita un juicio histórico sobre adicción a redes sociales. Snap ha llegado a un acuerdo para evitar un proceso judicial que podía sentar un precedente clave: considerar las redes sociales como productos inherentemente dañinos. El acuerdo no resuelve el debate, pero deja claro que el frente legal contra las plataformas está ahí.

🧠 Tesla reactiva Dojo 3 para computación de IA en el espacio. Dojo 3 ya no se concibe para entrenar coches autónomos en la Tierra, sino como infraestructura de IA espacial. Tesla explora escenarios donde el compute no depende de redes terrestres. La carrera por la soberanía computacional entra en una dimensión literal.

💻 AMD lanza un mini-PC de IA pensado para desarrolladores. El Ryzen AI Halo cabe en la palma de la mano, soporta hasta 128 GB de RAM y no impone sistema operativo. Un mensaje claro: la IA local, flexible y para builders vuelve a importar. Menos dependencia del cloud, más potencia en el edge.

🩺 La IA empieza a detectar señales invisibles en el metabolismo humano. Nuevos sistemas de IA son capaces de anticipar riesgos de diabetes o enfermedades cardiovasculares analizando patrones invisibles en la glucosa. No diagnostican enfermedades: predicen trayectorias. La medicina pasa de reaccionar a adelantarse.

💧El planeta cruza un umbral crítico en el acceso al agua. Más allá del clima, el agua emerge como uno de los grandes límites sistémicos. Escasez, mala gestión y estrés hídrico empiezan a definir estabilidad económica y social. La crisis climática ya no es futura: es logística.

🌍 El open source como columna vertebral invisible del ecosistema digital. Desde herramientas personales hasta infraestructuras críticas, el software libre sostiene gran parte del mundo digital sin hacer ruido. En un contexto de concentración tecnológica, el open source vuelve a ser una cuestión estratégica, no ideológica.

Déjame recordarte que si te gusta la tecnología, el podcast de Código Abierto también puede ser una buena opción.

Si algo de lo que has leído te ha removido, dímelo.

Ya sabes que estoy al otro lado si quieres comentar, discrepar o simplemente saludar.

Que nunca te falten ideas, ni ganas de probarlas.

A.

Para seguir tirando del hilo 🧵:

PD 1: Cuando el progreso se mide mal. The Measure of Progress de Diane Coyle es un recordatorio incómodo: lo que no se mide bien, se gestiona peor. Coyle explica por qué los indicadores tradicionales fallan al capturar valor real en economías basadas en conocimiento, intangibles… y ahora, IA.

PD2: Eficiencia antes que espectáculo. Cómo Hacer Grandes Cosas de Bent Flyvbjerg & Dan Gardner. No es un libro de IA, pero debería leerlo cualquiera que confunda potencia con progreso. Una lección brutal sobre costes ocultos, optimismo injustificado y por qué escalar sin eficiencia suele acabar mal.

PD3: El coste invisible de la complejidad. The Tyranny of Metrics de Jerry Z. Muller es un libro ideal para entender por qué obsesionarse con benchmarks (y rankings) puede distorsionar incentivos. Más métricas no siempre significan mejor juicio. A veces, justo lo contrario.

PD4: Cuando la fuerza bruta no sirve, y el compute no es la respuesta. En More from Less, Andrew McAfee hace un alegato optimista pero riguroso: el verdadero progreso económico viene de hacer más con menos. Muy conectado con la idea central del paper: capacidad útil por euro, no fuegos artificiales.